Especialistas em genética estão se aliando a forças policiais para gerar “retratos falados” sem ninguém para falar. Em vez de testemunhas, é o material genético do suspeito, encontrado em roupas, cabelos e secreções corporais, que dedura a fisionomia da pessoa. E tudo isso é feito com ajuda da inteligência artificial.

Fundada com dinheiro da Casa Branca, a norte-americana Parabon Nanolabs já usa a técnica para solucionar crimes em todo o mundo. Não sem polêmicas: um dos retratos indicava um jovem, enquanto o criminoso verdadeiro era um idoso; outro, indicando um homem negro, foi apontado como racista por ter sido divulgado pela polícia e exibido na TV. UFRGS (Universidade Federal do Rio Grande do Sul) e a Polícia Federal trabalham desde janeiro deste ano em um projeto que usa IA para criar imagens de suspeitos por meio de amostras de DNA.

Desde janeiro deste ano, Universidade Federal do Rio Grande do Sul e Polícia Federal recriam imagens de suspeitos com IA por meio de amostras de DNA. O projeto nasceu em 2015, fruto de uma parceria entre PUC-RS e PF.

Líder do projeto, a geneticista Clarice Alho explicou a Tilt que a ideia surgiu porque os bancos de dados internacionais não são adequados às características do Brasil, marcado pela miscigenação. “Eu mesmo tenho DNA mitocondrial indígena”, diz Clarice.

O plano é fazer a iniciativa chegar a uma base com dados de mil voluntários. Já há mais de 500, inicialmente todos do Rio Grande do Sul.

Além da coleta e do estoque de DNAs em construção, o modelo de IA já está pronto.O passo ainda não executado é a execução. Acionada pela reportagem, a PF não respondeu o pedido de entrevista.

A PF não está fazendo [retratos falados por DNA] ainda porque não tem uma legislação de suporte. Não está sendo feito por questões éticas, legais, morais. Estamos fazendo um treinamento de máquina para o futuro, quando for possível. Clarice Alho, geneticista

A Justiça brasileira aceita amostras de DNA como provas. A Lei de Execução Penal inclusive permite que suspeitos sejam forçados a prover amostras, em crimes contra a vida, liberdade sexual e vulneráveis.

Não há, porém, legislação sobre “retrato-falado” criado por DNA. Em outra linha, um projeto de lei, o PL 1.496, tenta obrigar a coleta do DNA de todos os condenados por crimes dolosos, com o objetivo de criar uma imensa base de dados.

Os genes falam, mas não tudo

Tecnicamente chamada de fenotipização por DNA, a técnica consiste na reconstrução do aspecto físico -o fenótipo— de um desconhecido, por meio de evidências em seus genes.

Capitaneada pela Parabon Nanolabs, a análise funciona assim:

- Informações genéticas achadas em cenas de crime ou outras evidências, como objetos ligados ao suspeito, são levadas à análise.

- Essas amostras revelam informações relativamente básicas ligadas aos genes, como sexo, cor de olhos, da pele e dos cabelos. Também mostra a ancestralidade (se tem ascendentes europeus, indígenas, africanos etc) da pessoa e em qual proporção, baseada em variações regionais de diversos genes;

- Os dados genéticos alimentam uma inteligência artificial que vasculha um banco de dados contendo os rostos e dados genéticos de milhares de pessoas. A partir da similaridade genética, a IA prevê como seria o rosto do indivíduo.

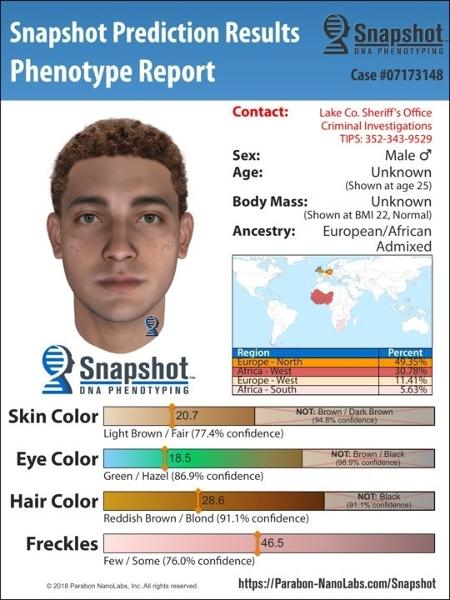

O resultado é uma imagem como a abaixo:

A imagem mostra:

- A percentual de regiões originárias na composição pessoa – majoritariamente europeia (49,35%), mas com cerca de 37% do material genético vindo de Leste e Sul da África.

- A previsão da existência de sardas (“freckles”), de 46,5% (informação com 76% de confiança)

- A cor dos cabelos (com chance de 91,1% de estar certa).

A empresa afirma ter ajudado a resolver mais de 230 casos, sem detalhar o número exato por haver vários em andamento.

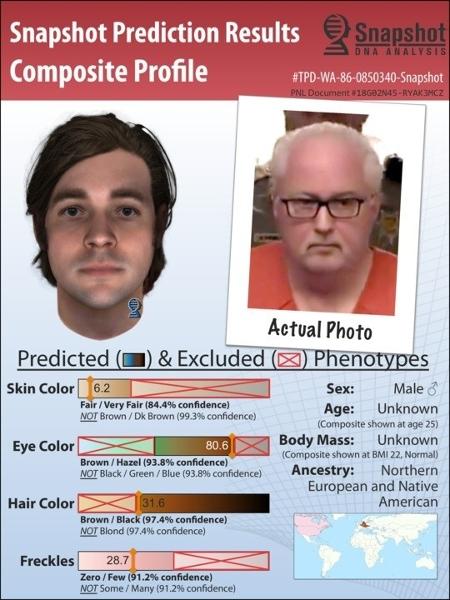

Quando uma prisão ocorre, a Parabon exibe em seu site a imagem prevista por sua tecnologia e a foto real do suspeito. Há até uma página de pôsteres para isso.

Tecnologia controversa

Nem sempre os resultados batem. Genes não são capazes de determinar a idade, o índice de massa corporal (isto é, o peso) e várias características adquiridas ao longo da vida, como cicatrizes e tatuagens. O formato do rosto também é uma estimativa mais vaga que a cor dos olhos e do cabelo.

Não raro, a ferramenta erra a idade do suspeito.

Em entrevista a Tilt, Ellen Greytak, diretora de bioinformática da Parabon, reconhece a limitação da tecnologia, mas defende o método.

Uma predição de fenótipo é uma evidência investigativa, como o testemunho de uma vítima. Ajuda os detetives a realizar sua investigação, mas é a comparação tradicional do perfil de DNA que confirma a identidade e é usada para prisão e condenação. O uso primário de fenotipização deveria ser para excluir indivíduos [de uma investigação] que claramente não preenchem a descrição, seguido por priorizar suspeitos que preenchem. Ellen Greytak, diretora de bioinformática da Parabon

Críticos, porém, enxergam outros problemas. Para o sociólogo Acácio Augusto, da Universidade Federal de São Paulo, é muito alta a possibilidade de a tecnologia absorver os preconceitos de gênero, raça e classe.

“Quem opera e quem programa essas coisas [AI] são humanos. Não me surpreenderia se, se passássemos a usar esse tipo de tecnologia, ela tivessse um resultado muito parecido com que já é a clientela do sistema de Justiça Criminal: pobre, homem, jovem, negro, basicamente.”

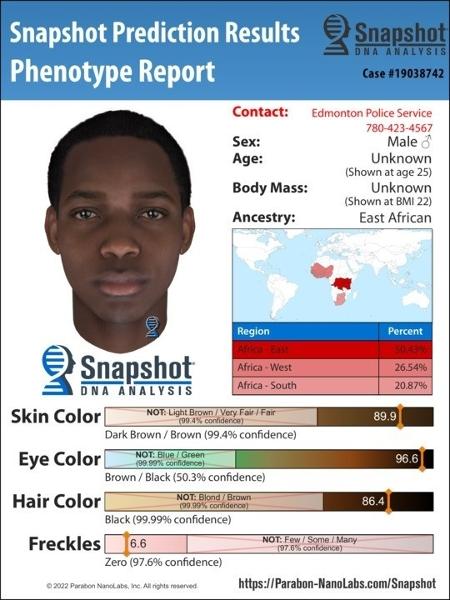

É basicamente como as coisas já estão sendo vistas onde a técnica é usada. A imagem abaixo causou uma crise de relações públicas à Parabon.

A polícia de Edmonton, no Canadá, procurou a empresa para tentar resolver um caso de estupro ocorrido em 2019. Ao receber a análise da empresa, em outubro de 2022, divulgou a imagem à imprensa e pelo seu site. Era, segundo os policiais, um “último recurso” para encontrar o suspeito. Diante de um turbilhão de acusações de racismo em redes sociais, os policiais tiveram que remover a imagem do site e pedir desculpas. O caso não foi resolvido.

Se chamar um algoritmo de racista soa exagero, é bom lembrar que a divulgações de imagens como a acima não acontece num vácuo, mas num contexto em que racismo é um problema vivo, em particular com forças de repressão.

A fenotipização pode prever coisas muito amplas como gênero, cor dos cabelos, cor dos olhos, talvez altura etc., mas essas tem uma grande variação em previsibilidade. “Isso deixa a polícia na posição de saber (talvez) que estão buscando (por exemplo) um homem negro de 1,78 m. Como isso ajuda? Eles vão tentar interrogar ou investigar cada homem negro de 1,78 m na área? Isso seria uma imensa violação de privacidade e liberdades civis. Calli Schroeder, conselheira da ONG Electronic Privacy Information Center (“Centro de Informações Sobre Privacidade Eletrônica”), apoiada pelo governo dos Estados Unidos

Grupos minoritários podem ser particularmente vulneráveis a danos dessa tecnologia, como já são frequentemente e desproporcionalmente alvo de investigações. Isso ainda pode aumentar o preconceito do público e das forças de repressão e tornar grupos vulneráveis propensos a sofrer de vigilantismo [isto é, perseguição justiceira, linchamentos]. Calli Schroeder

A geneticista Clarice Alho explica que as preocupações com usos racistas da tecnologia fizeram parte da criação do projeto. Para Ellen Greytak, o problema foi a polícia ter divulgado a foto ao público, quando a recomendação da empresa é outra.

A maior parte das agências [policiais] usa as imagens internamente, para excluir suspeitos. Quando uma agência decide soltar a informação publicamente, insistimos que a previsão inteira seja mostrada, não só a composição [isto é, a imagem gerada], para deixar claro que é só uma previsão. Ellen Greytak, diretora de bioinformática da Parabon

A pesquisadora da UFRGS concorda: imagens geradas pela tecnologia nunca deveriam gerar cartazes tipo “Procura-se”. “Isso seria totalmente de uso privado da polícia.”

Para os críticos, porém, não se trata de um problema de relações públicas. Toda a tecnologia é um equívoco. Para Acácio, a ferramenta é exemplo de uma espécie de “solucionismo do Vale do Silício”.

Para qualquer problema, inclusive social, surge um app. App para emagrecer, para parar de fumar, agora um app num contexto policial. Acácio Augusto, sociólogo da Unifesp

As agências de repressão sempre vai se empolgar com as promessas de tecnologias que podem tornar seu trabalho mais fácil. Mas o entusiasmo delas aqui está mal direcionado. Não apenas essa tecnologia dificilmente poderá gerar informação mais precisa sobre suspeitos de crimes, mas ela pode levar a polícia em direções erradas e por em risco pessoas inocentes. Calli Schroeder